We praten de hele tijd over computers die ons begrijpen. We zeggen dat Google 'wist' waar we naar op zoek waren, of dat Cortana 'heeft' wat we zeiden, maar 'begrijpen' is een heel moeilijk concept. Vooral als het om computers gaat.

Eén veld van computertaalkunde, genaamd natuurlijke taalverwerking (NLP), werkt aan dit bijzonder moeilijke probleem. Het is op dit moment een fascinerend veld en als je eenmaal een idee hebt hoe het werkt, zul je overal de effecten ervan zien.

Een korte opmerking: dit artikel bevat enkele voorbeelden van een computer die reageert op spraak, bijvoorbeeld wanneer u Siri om iets vraagt. De transformatie van hoorbare spraak naar een door de computer begrijpelijk formaat wordt spraakherkenning genoemd. NLP maakt zich daar niet druk om (tenminste niet in de hoedanigheid die we hier bespreken). NLP komt pas in beeld als de tekst gereed is. Beide processen zijn noodzakelijk voor veel toepassingen, maar het zijn twee heel verschillende problemen.

Definiëren van begrip

Voordat we ingaan op de manier waarop computers omgaan met natuurlijke taal, moeten we een paar dingen definiëren.

Allereerst moeten we de natuurlijke taal definiëren. Dit is een gemakkelijke: elke taal die regelmatig door mensen wordt gebruikt, valt in deze categorie. Het omvat geen dingen zoals geconstrueerde talen (Klingon, Esperanto) of computer programmeertalen. Je gebruikt natuurlijke taal als je met je vrienden praat. U gebruikt het waarschijnlijk ook om met uw digitale persoonlijke assistent te praten.

Dus wat bedoelen we met begrip? Wel, het is complex. Wat betekent het om een zin te begrijpen? Misschien zou je zeggen dat het betekent dat je nu de bedoelde inhoud van de boodschap in je brein hebt. Het begrijpen van een concept kan betekenen dat je dat concept op andere gedachten kunt toepassen.

Woordenboekdefinities zijn vaag. Er is geen intuïtief antwoord. Filosofen hebben al eeuwen over dit soort dingen gepleit.

Voor onze doeleinden gaan we zeggen dat begrip het vermogen is om betekenis betekenisvol uit natuurlijke taal te halen . Voor een computer om te begrijpen, moet het een inkomende stroom van spraak nauwkeurig verwerken, die stroom omzetten in eenheden van betekenis, en in staat zijn om te reageren op de invoer met iets dat nuttig is.

Uiteraard is dit allemaal erg vaag. Maar het is het beste wat we kunnen doen met beperkte ruimte (en zonder een graad neurofilosofie). Als een computer een menselijke, of op zijn minst nuttige, reactie op een stroom van natuurlijke taalinvoer kan bieden, kunnen we zeggen dat hij begrijpt. Dit is de definitie die we in de toekomst zullen gebruiken.

Een complex probleem

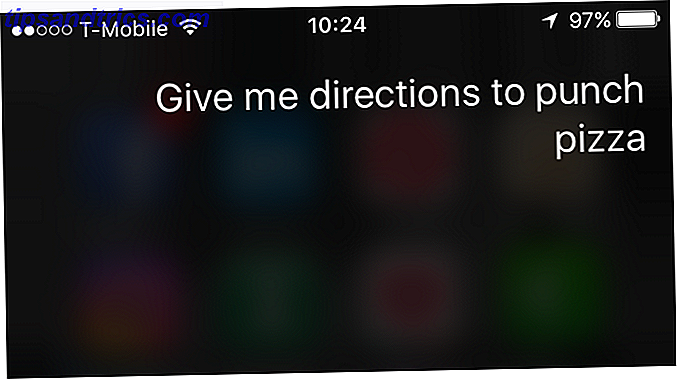

Natuurlijke taal is erg moeilijk voor een computer om mee om te gaan. Je zou kunnen zeggen: "Siri, geef me een routebeschrijving naar Punch Pizza, " terwijl ik zou zeggen, "Siri, Punch Pizza-route alstublieft".

In uw verklaring kan Siri de sleutelzin "geef mij aanwijzingen" kiezen en voer vervolgens een opdracht uit met betrekking tot de zoekterm "Punch Pizza". In de mijne moet Siri echter "route" als zoekwoord selecteren en weten dat " Punch Pizza "is waar ik naartoe wil, niet" alstublieft. "En dat is slechts een simplistisch voorbeeld.

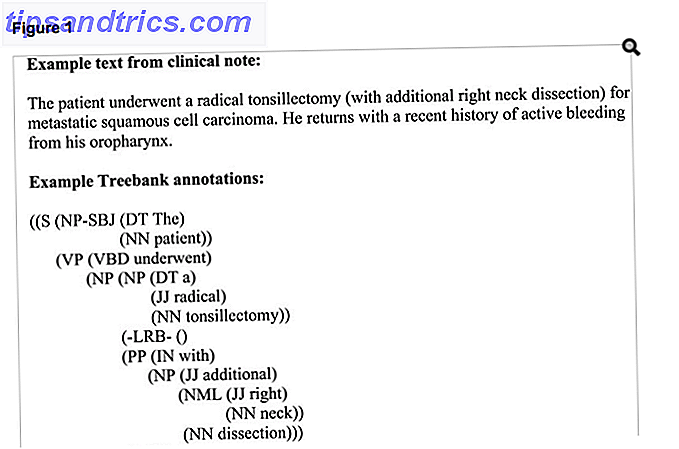

Denk aan een kunstmatige intelligentie die e-mails leest en beslist of ze al dan niet oplichterij zijn. Of een die sociale mediaposten monitort om de interesse in een bepaald bedrijf te peilen. Ik heb ooit gewerkt aan een project waarbij we een computer moesten leren medische notities te lezen (die allerlei vreemde conventies hebben) en er informatie van op te halen.

Dit betekent dat het systeem in staat moest zijn om afkortingen, vreemde syntaxis, occasionele spelfouten en een grote verscheidenheid aan andere verschillen in de noten te verwerken. Het is een zeer complexe taak die zelfs voor ervaren mensen moeilijk kan zijn, en veel minder voor machines.

Een voorbeeld instellen

In dit specifieke project maakte ik deel uit van het team dat de computer leerde om specifieke woorden en de relaties tussen woorden te herkennen. De eerste stap van het proces was om de computer de informatie te tonen die elke notitie bevatte, dus we annoteerden de notities.

Er waren een groot aantal verschillende categorieën entiteiten en relaties. Neem de zin "Ms. De hoofdpijn van Green werd behandeld met ibuprofen, "bijvoorbeeld. Mevrouw Green werd getagd als PERSOON, hoofdpijn werd getagd als SIGN OF SYMPTOOM, ibuprofen werd getagd als MEDICATION. Toen werd mevrouw Green in verband gebracht met hoofdpijn met een PRESENTS-relatie. Ten slotte werd ibuprofen gekoppeld aan hoofdpijn met een TREATS-relatie.

We hebben op deze manier duizenden aantekeningen getagd. We codeerden diagnoses, behandelingen, symptomen, onderliggende oorzaken, comorbiditeiten, doseringen en al het andere dat je maar kunt bedenken in verband met medicijnen. Andere annotatieteams codeerden andere informatie, zoals de syntaxis. Uiteindelijk hadden we een corpus vol medische aantekeningen die de AI kon 'lezen'.

Lezen is net zo moeilijk om te definiëren als begrip. De computer kan gemakkelijk zien dat ibuprofen hoofdpijn heeft, maar wanneer het die informatie leert, wordt het omgezet in betekenisloze (voor ons) enen en nullen. Het kan zeker informatie teruggeven die menselijk lijkt en nuttig is, maar is dat een begrip? Wat is kunstmatige intelligentie niet wat kunstmatige intelligentie niet is? Intelligente, bewuste robots die de wereld overnemen? Niet vandaag - en misschien ook nooit. Lees verder ? Nogmaals, het is grotendeels een filosofische vraag.

Het echte leren

Op dit punt ging de computer door de notities en paste een aantal algoritmen toe voor het aanleren van de machine. 4 Algoritmes voor het leren van de machine die uw leven bepalen 4 Algoritmen voor machinaal leren die uw leven bepalen U realiseert het misschien niet maar machine learning is al overal om u heen, en het kan een verrassende mate van invloed uitoefenen op je leven. Geloof me niet? Je zult verrast zijn. Lees verder . Programmeurs ontwikkelden verschillende routines voor het labelen van delen van spraak, het analyseren van afhankelijkheden en kiesdistricten en het labelen van semantische rollen. In wezen leerde de AI de noten te 'lezen'.

Onderzoekers zouden het uiteindelijk kunnen testen door het een medische notitie te geven en het te vragen elke entiteit en relatie te labelen. Wanneer de computer menselijke aantekeningen nauwkeurig reproduceerde, zou je kunnen zeggen dat het leerde hoe de medische notities moesten worden gelezen.

Daarna was het gewoon een kwestie van enorm veel statistieken verzamelen over wat het had gelezen: welke medicijnen worden gebruikt om welke stoornissen te behandelen, welke behandelingen het meest effectief zijn, de onderliggende oorzaken van specifieke symptomen, enzovoort. Aan het einde van het proces zou de AI in staat zijn om medische vragen te beantwoorden op basis van bewijs uit feitelijke medische notities. Het hoeft niet te vertrouwen op schoolboeken, farmaceutische bedrijven of intuïtie.

Diepgaand leren

Laten we naar een ander voorbeeld kijken. Het DeepMind neurale netwerk van Google leert nieuwsartikelen lezen. Net als de biomedische AI hierboven, wilden onderzoekers dat het relevante en bruikbare informatie uit grotere stukken van de tekst haalt.

Het trainen van een AI op medische informatie was al moeilijk genoeg, dus je kunt je voorstellen hoeveel geannoteerde gegevens je nodig hebt om een AI in staat te stellen algemene nieuwsartikelen te lezen. Het inhuren van genoeg annotators en het doornemen van voldoende informatie zou onbetaalbaar en tijdrovend zijn.

Dus het DeepMind-team wendde zich tot een andere bron: nieuwswebsites. Met name CNN en de Daily Mail.

Waarom deze sites? Omdat ze opsommingstekens van hun artikelen bevatten die niet zomaar zinnen uit het artikel zelf halen. Dat betekent dat de AI iets heeft om van te leren. Onderzoekers vertelden in feite aan de AI: "Hier is een artikel en hier is de belangrijkste informatie in." Vervolgens vroegen ze het om hetzelfde soort informatie uit een artikel te halen zonder opsommingstekens.

Dit niveau van complexiteit kan worden aangepakt door een diep neuraal netwerk, dat een bijzonder gecompliceerd type machine-leersysteem is. (Het DeepMind-team doet verbazingwekkende dingen in dit project. Om meer details te krijgen, bekijk dit geweldige overzicht van de MIT Technology Review.)

Wat kan een lees-AI doen?

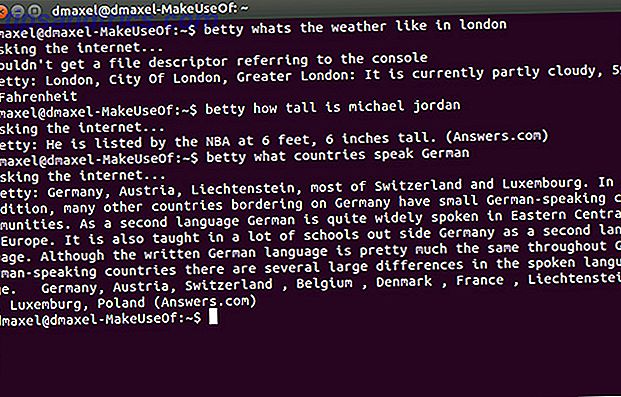

We hebben nu een algemeen begrip van hoe computers leren lezen. Je neemt een enorme hoeveelheid tekst, vertelt de computer wat belangrijk is en past algoritmen voor het leren van apparaten toe. Maar wat kunnen we doen met een AI die informatie uit tekst haalt?

We weten al dat u specifieke, bruikbare informatie uit medische aantekeningen kunt halen en algemene nieuwsartikelen kunt samenvatten. Er is een open-sourceprogramma genaamd PAN dat poëzie analyseert door thema's en beelden naar voren te halen. Onderzoekers gebruiken vaak machine learning om grote hoeveelheden sociale mediadata te analyseren, die door bedrijven worden gebruikt om gebruikerssensaties te begrijpen, te zien waar mensen het over hebben en om nuttige patronen voor marketing te vinden.

Onderzoekers hebben machinaal leren gebruikt om inzicht te krijgen in e-mailgedrag en de effecten van e-mailoverbelasting. E-mailproviders kunnen dit gebruiken om spam uit uw inbox te filteren en sommige berichten als hoge prioriteit te classificeren. Het lezen van AI's is van cruciaal belang voor het maken van effectieve chatbots voor klantenservices 8 bots die u moet toevoegen aan uw Facebook Messenger-app 8 bots die u moet toevoegen aan uw Facebook Messenger-app Facebook Messenger heeft zich opengesteld voor chat-bots, waardoor bedrijven klantenservice, nieuws en directer kunnen leveren om u via de app. Hier zijn enkele van de beste die beschikbaar zijn. Lees verder . Overal waar tekst is, werkt een onderzoeker aan natuurlijke taalverwerking.

En naarmate dit type machine learning verbetert, nemen de mogelijkheden alleen maar toe. Computers zijn nu beter dan mensen bij schaak-, Go- en videogames. Al snel zijn ze misschien beter in lezen en leren. Is dit de eerste stap op weg naar een sterke AI? Waarom wetenschappers denken dat je je zorgen moet maken over kunstmatige intelligentie, hier is waarom wetenschappers denken dat je je zorgen moet maken over kunstmatige intelligentie Denk je dat kunstmatige intelligentie gevaarlijk is? Kan AI een ernstig risico vormen voor de mensheid. Dit zijn enkele redenen waarom u zich misschien zorgen wilt maken. Lees verder ? We zullen moeten afwachten, maar het kan zijn.

Welke soorten toepassingen ziet u voor het lezen van tekst en het leren van AI? Wat voor soort machine learning denk je dat we in de nabije toekomst zullen zien? Deel je mening in de comments hieronder!

Afbeeldingscredits: Vasilyev Alexandr / Shutterstock

![Besturingsvirus scant vanaf de commandolijn met Clam Antivirus [Linux]](https://www.tipsandtrics.com/img/linux/423/control-virus-scans-from-command-line-with-clam-antivirus.png)