Als je de mentale karbonades hebt, een flair voor programmeren en vertellen, en een oog voor design, kun je het slechter doen dan in de data science stappen. Het is het nieuwe grote ding in technologie; zeer trendy en goed betaald, waarbij data-wetenschappers worden gezocht door enkele van de grootste bedrijven ter wereld.

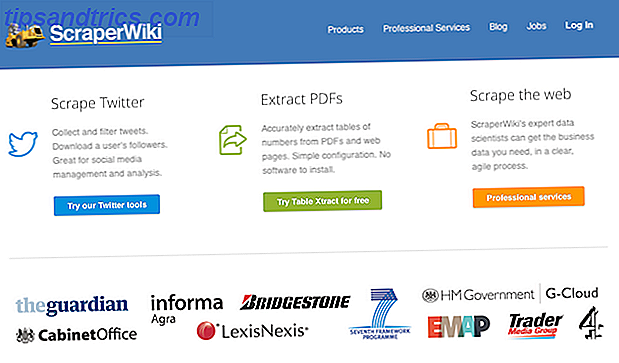

ScraperWiki is een bedrijf dat al lang in verband wordt gebracht met het domein van de gegevenswetenschap. Sinds enkele jaren biedt deze op Liverpool gebaseerde startup een platform voor codeerders om tools te schrijven die gegevens verzamelen, opschonen en analyseren in de cloud.

Met een recente opfrissing en de steeds toenemende vraag naar data scientists in de onderneming, is het de moeite waard om eens goed naar ScraperWiki te kijken.

Volledige openbaarmaking: ik studeerde afgelopen zomer bij ScraperWiki.

Wat doet ScraperWiki?

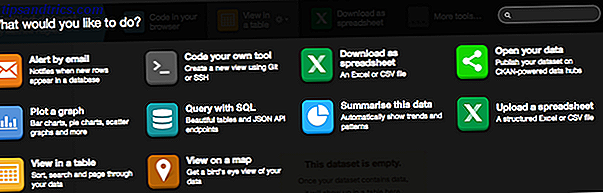

ScraperWiki brengt zichzelf op de markt als een plaats om data te krijgen, op te ruimen en te analyseren, en het levert op elk van die punten. In de eenvoudigste vorm, kunt u - de gebruiker - een plaats zijn waar u code kunt schrijven die gegevens uit een bron ophaalt, hulpmiddelen om het in een formaat om te zetten dat gemakkelijk te analyseren is en opslag om het voor latere visualisatie te behouden - wat u kan ook omgaan met ScraperWiki.

Het komt ook met een aantal vooraf gebouwde tools die repetitieve taken automatiseren, inclusief het verkrijgen van gegevens uit PDF's, die notoir moeilijk te decoderen zijn. Dit is een aanvulling op het zoeken op Twitter 5 Cool Twitter Search Tricks om te volgen wat mensen over u zeggen 5 Cool Twitter Search Tricks om te volgen Wat anderen over u zeggen Als u een website heeft of gewoon online geld wilt verdienen als freelancer, het is altijd goed om te weten wat mensen over je zeggen via internet. Mensen citeren misschien ... Lees meer en schrapen nutsbedrijven. U hebt geen softwareontwikkelervaring nodig om deze te gebruiken.

Kosten

Zoals eerder vermeld, omhelst ScraperWiki het prijsmodel van freemium en biedt het een service aan met meerdere niveaus. Wie net begint met data science of met beperkte behoeften kan gebruik maken van de gratis service. Dit geeft u drie datasets - waar u uw gegevens en code opslaat.

Wie van plan is om meerdere scrapers te schrijven of bergen van data-analyse wil doen, kan wat contant geld verdienen voor een premium account. Deze beginnen bij $ 9 per maand en bieden 10 datasets. Als dat nog steeds niet genoeg is, kunt u altijd upgraden naar hun hoogste niveau met 100 datasets en kost $ 29 per maand.

Coding

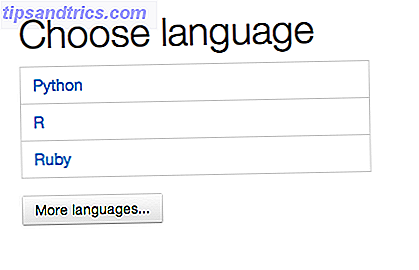

Programmeurs zijn vaak behoorlijk kieskeurig als het gaat om hoe ze coderen. Sommigen geven de voorkeur aan scripttalen boven gecompileerde talen. Sommigen geven de voorkeur aan de eenvoudige ervaring van een teksteditor boven die van een geïntegreerde ontwikkelomgeving (IDE). ScraperWiki herkent dat, en geeft de gebruiker enorm veel keuze als het gaat om hoe je je code schrijft.

Als je zo geneigd bent, kun je je code in de browser schrijven. Zoals je mag verwachten van professionele webgebaseerde De Top 3 browser-gebaseerde IDE's Naar Code In The Cloud De Top 3 Browser-gebaseerde IDE's naar code in de cloud Lees meer ontwikkeltool, deze wordt geleverd met functies die elke programmeur zou essentieel zijn, zoals syntax highlighting.

Er zijn een aantal talen beschikbaar. Deze omvatten Python De 5 beste websites om Python te leren programmeren De 5 beste websites om Python te leren programmeren In het afgelopen decennium is de programmeertaal van Python enorm populair geworden onder programmeurs in alle codeergebieden. Van webontwikkelaars tot videogamedesigners tot interne toolmakers, veel mensen zijn gevallen in ... Lees meer, een populaire scriptingtaal die wordt gebruikt door Google en NASA; Ruby 3 Interactief, leuk, gratis manieren om te leren De Ruby programmeertaal 3 Interactief, leuk, gratis manieren om te leren De Ruby programmeertaal Ruby is een expressieve scripttaal van zeer hoog niveau. Het wordt voornamelijk op internet gebruikt als onderdeel van het webontwikkelingskader van Ruby on Rails, maar ook als standalone. Als je nieuwsgierig bent naar wat Ruby is (niet ... Lees meer, wat een aantal populaire websites zoals Living Social aandrijft, en de populaire statistische analyse-taal, R.

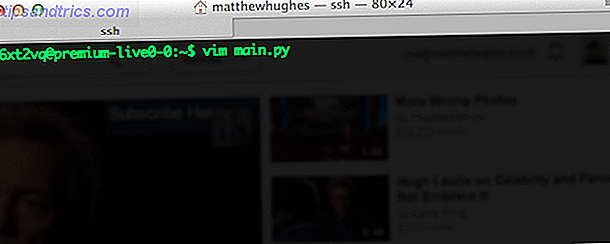

Bovendien kunt u ook code vanaf de opdrachtregel schrijven met behulp van SSH, Git en elke teksteditor die u graag gebruikt. Ja, je leest het goed. SSH Wat SSH is en hoe het anders is Van FTP [Technologie verklaard] Wat SSH is en hoe het anders is Van FTP [Technologie uitgelegd] Meer lezen. Elke box die je gebruikt is zijn eigen Linux-account en je kunt er verbinding mee maken zoals je een VPS of een ander shell-account zou doen. Er zijn een aantal teksteditors beschikbaar, waaronder Vim The Top 7 Redenen om The Vim Text Editor een kans te geven De Top 7 Redenen om The Vim Text Editor een kans te geven Jarenlang heb ik de ene teksteditor na de andere geprobeerd. U noemt het, ik probeerde het. Ik gebruikte elke en elke bewerker voor meer dan twee maanden als mijn primaire dag-tot-dag editor. Een of andere manier, ik ... Lees meer die kan worden uitgebreid met plug-ins en door de configuratie aan te passen. Degenen die worden geïntimideerd door Vim kunnen Nano gebruiken, wat een lichtgewicht teksteditor van de opdrachtregel is.

De geïnstalleerde bibliotheken moeten voldoende zijn voor schrijfhulpmiddelen om gegevens op te halen en te verwerken. Als u iets meer obscuur wilt, kunt u altijd een virtualenv maken vanaf de opdrachtregel. Zoals je ziet, is er een enorme hoeveelheid flexibiliteit aan ontwikkelaars.

Data visualisatie

Dus je hebt je gegevens. Je hebt het genormaliseerd. Je hebt het schoongemaakt. Je hebt het geanalyseerd. Nu is het tijd om wat te visualiseren en de wereld te laten zien wat je hebt geleerd.

ScraperWiki stelt ontwikkelaars in staat om hun gegevens weer te geven met behulp van webpagina's opgebouwd uit de vertrouwde trifecta van HTML, CSS en JavaScript. Bootstrap-componenten worden bovendien out-of-the-box ondersteund.

Er zijn een aantal vooraf gemaakte visualisaties beschikbaar, waaronder degene die uw gegevens op een kaart plotten en trends binnen uw bevindingen vinden. Om deze te gebruiken, moet u ervoor zorgen dat uw gegevens worden opgeslagen als SQLite-bestand met de bestandsnaam 'scraperwiki.sqlite'. Voeg vervolgens gewoon de visualisatie toe waarin u bent geïnteresseerd. Eenvoudig, toch?

Conclusie

ScraperWiki biedt veel aan ontwikkelaars die wat data-analyse willen doen zonder dat hun ontwikkelomgeving hen hindert, terwijl ze de flexibiliteit hebben om zelfs de meest veeleisende gebruikers tevreden te stellen. Maar wat denk je ervan? Laat het me weten in de reacties hieronder.

Photo Credit: Rocket Science (Dan Brown)